Las Inteligencias Artificiales (IA) se han convertido en nuestras compañeras de juego, pues nos permiten preguntarles de todo y nos contestan con obras de arte, gráficas o literarias, pero hay que tomar en cuenta que, actualmente, una IA no puede crear algo novedoso, sino que imita los muchos datos a su disposición… entonces si la IA no se lo inventó, ¿de dónde salen sus respuestas?

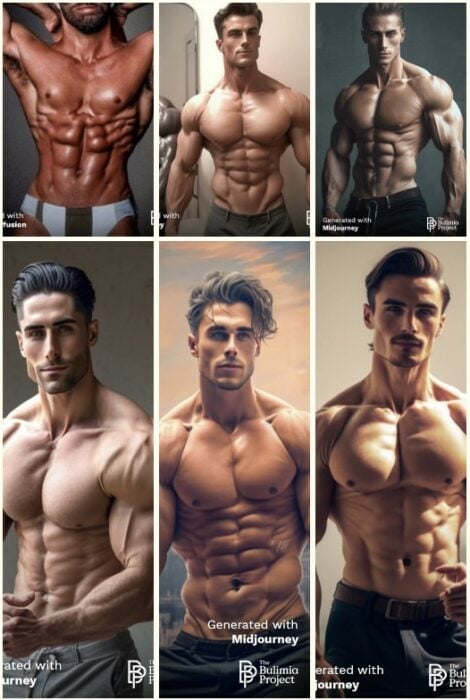

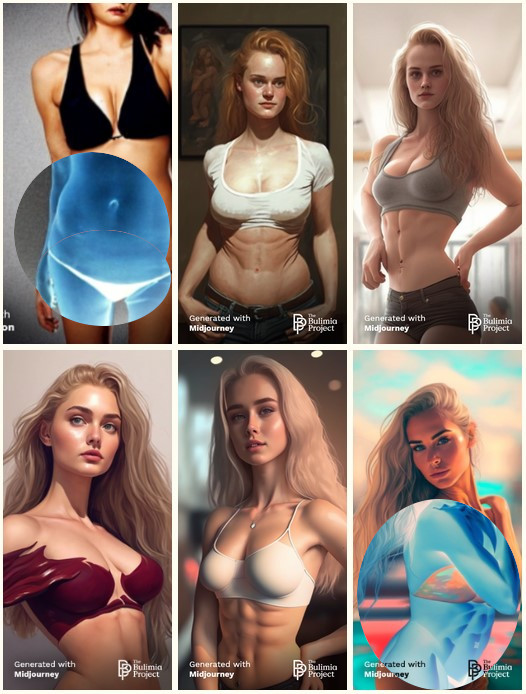

Como parte de un esfuerzo por demostrar que nuestros estándares de perfección están fundamentalmente viciados, el Bulimia Project, un grupo dedicado a hablar sobre los desórdenes alimenticios y sus efectos, le preguntó al generador de imágenes Midjourney cómo se verían el hombre y la mujer perfectos y los resultados fueron imágenes racistas y comprometidas con un ideal de belleza comercial y poco realista.

El modelo ideal… ¿de quién?

Los resultados del pequeño experimento de The Bulimia Project son sorprendentes y perturbadores, pues, aparentemente, son un reflejo de las convenciones de perfección que están encaminados a mostrarnos a modelos inspirados en la descontinuada noción de la raza caucásica, agregando algunos elementos woke, como piel con tonalidades oliva, cabello rubio o castaño y ojos cafés.

En lugar de haber dado una respuesta filosófica, antropológica, médica o incluso artística, la IA nos ha dado respuestas estadísticas que caen más en lo comercial que en ningún otro rubro. Esto sin duda creará complejos y provocará sentimiento de inseguridad a quienes no cumplan con las estrictas e irreales expectativas de las IA, que, según los investigadores, parecen ser imágenes photoshopeadas de fisicoculturistas.

Según los resultados reportados por The Bulimia Project, la computadora mostrará:

- “Ideal” para las mujeres: Cabello rubio (37 por ciento de las imágenes), ojos cafés (30 por ciento de las imágenes), piel oliva (53 por ciento de las imágenes)

- “Ideal” para los hombres: Cabello castaño (67 por ciento de las imágenes), ojos cafés (23 por ciento de las imágenes), piel oliva (63 por ciento de las imágenes) y vello facial (47 por ciento de las imágenes)

Las computadoras racistas y tontas: la buena educación empieza en casa

Ya en el pasado se habían hecho observaciones de que en sistemas inteligentes que funcionan a base de IA, los resultados no favorecían a ciertos grupos poblacionales, como a las personas de color, que estaban en más peligro que quienes tienen piel clara. Ese mismo sesgo cognitivo se extiende, aparentemente, a las Inteligencias Artificiales que tienen como objetivo hacer representaciones artísticas.

¿Pero realmente debemos culpar a las computadoras? A final de cuentas, quienes afinan y definen los parámetros que han de seguir los algoritmos de aprendizaje, así como la decisión de qué información es pertinente para alguna cuestión somo los humanos, es decir, si las respuestas de las IA resultan racistas e irreales, es solo un reflejo de lo que nosotros les hemos enseñado.