Los automóviles autónomos, “sin conductor”, “conducidos” o “robóticos”, son aquellos que pueden emular el manejo de un ser humano para transportar a sus pasajeros. Para ello, se valen de tecnología que les permite percibir su medio y controlar al vehículo. Esto incluye a peatones y obstáculos.

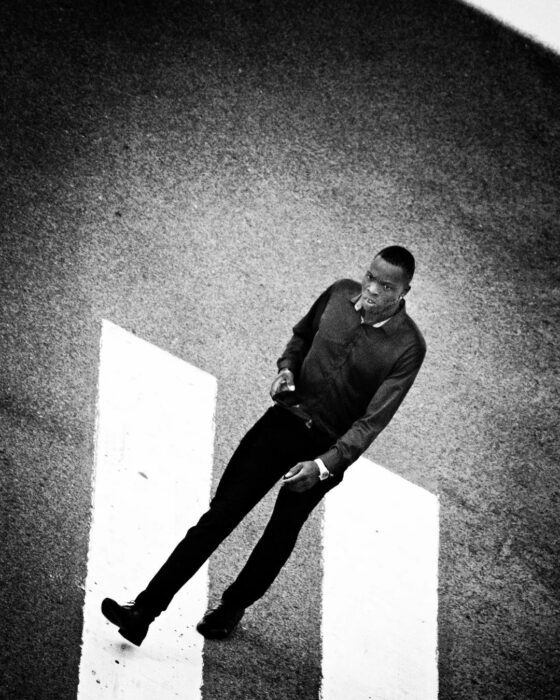

Con la popularización de esta tecnología, se han empezado a notar algunos detalles en cuanto al desempeño de los dispositivos encargados de los vehículos autónomos y llama la atención que su inteligencia artificial (IA) parece no responder “tan bien” cuando se trata de evitar atropellar a un peatón con tonos oscuros de piel. ¿Es una limitación técnica o tecnología racista?

Discriminación tecnológica

El reporte Inequidad predictiva en detección de objetos (2019) señala el problema de detección de peatones con tonos de piel oscuros y al hacer hincapié en que, independientemente de la dificultad inherente a la precisión y confiabilidad de los sistemas de visión, los peatones con tez más clara son reconocidos con mayor frecuencia y consistencia.

Si bien los sistemas de visión no son perfectos, sí es posible diseñarlos y calibrarlos para proteger a la mayor cantidad de personas posible y aunque se ha dicho que simples ajustes durante el “periodo de aprendizaje” de los sistemas podrían ayudar, los desarrolladores no se han tomado esa propuesta entusiastamente.

No solo le ocurre a los vehículos sin conductor

El problema para reconocer a gente de color que presentan los sistemas de inteligencia artificial existe a muchos niveles y, por supuesto, no se limita a desarrollos en la industria automotriz.

Anteriormente, el software de reconocimiento facial Rekognition se volvió infame por no poder reconocer tonos oscuros de piel y confundir a mujeres de color con hombres. Además, hubo un escándalo por cómo confundió a miembros del Congreso con fotos de archivos criminales.

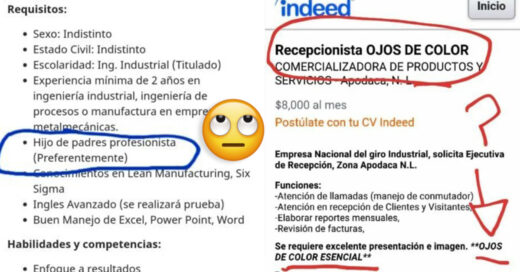

Sesgo intencional

Durante una famosa impugnación al sistema empleado para determinar si un individuo representa un alto riesgo o un bajo riesgo de incidir o reincidir en comportamientos criminales, la organización ProPublica puso en tela de juicio la imparcialidad de la justicia asistida por software.

El programa en cuestión, Administrador de Perfilado de Ofensores Correccionales para Sanciones Alternativas (COMPAS, por sus siglas en inglés), fue desarrollado por Northpointe (ahora Equivant) y ha sido usado activamente a pesar de su probada inclinación a emitir “evaluaciones parciales” basándose en el tono de piel del evaluado.

¿Por qué ocurre esto?

Debido a que en los estudios que han detectado lo inequitativo de los sistemas de conducción autónoma se han tomado en cuenta factores como hora del día, iluminación discreta u obstrucciones casuales, sin que se vieran alterados los resultados, se cree que la discriminación equivocada del cinco por ciento en perjuicio de la gente con piel oscura no es un error o limitación de la tecnología.

El sistema de conducción de los vehículos requiere de programación y “aprendizaje” para poder tomar decisiones, pero dado que los algoritmos y la “instrucción” son proveídos por personas que a su vez son parte de compañías con ciertas ideologías, esto puede afectar el modo en que son desarrollados sus productos. Por ejemplo, en 2015, el reconocimiento facial de Google etiquetó afroamericanos como gorilas y aunque se reporta como un error, es difícil no sospechar de mala fe.

El futuro

Se espera que para 2040 hasta 33 millones de autos autónomos estén en circulación. Sus entusiastas aseguran que esto eliminaría la mayoría del peligro que significa que un humano cometa errores debidos al enfado, la distracción, el agotamiento o la intoxicación alcohólica. Sin embargo, otros problemas aparecerían, como el sesgo en los sistemas automatizados.

Las limitantes de la tecnología aparte, la igualdad al momento de calibrar y desarrollar todo tipo de controles automatizados no debería, jamás, afectar la justicia y estas medidas de protección a los usuarios deberían ser implementadas del modo más universal posible.